Robots.txt, UTF-8 BOM et SEO : Comment repérer et corriger le problème des caractères invisibles ?

Par Pierre Monclin - 2 novembre 2019

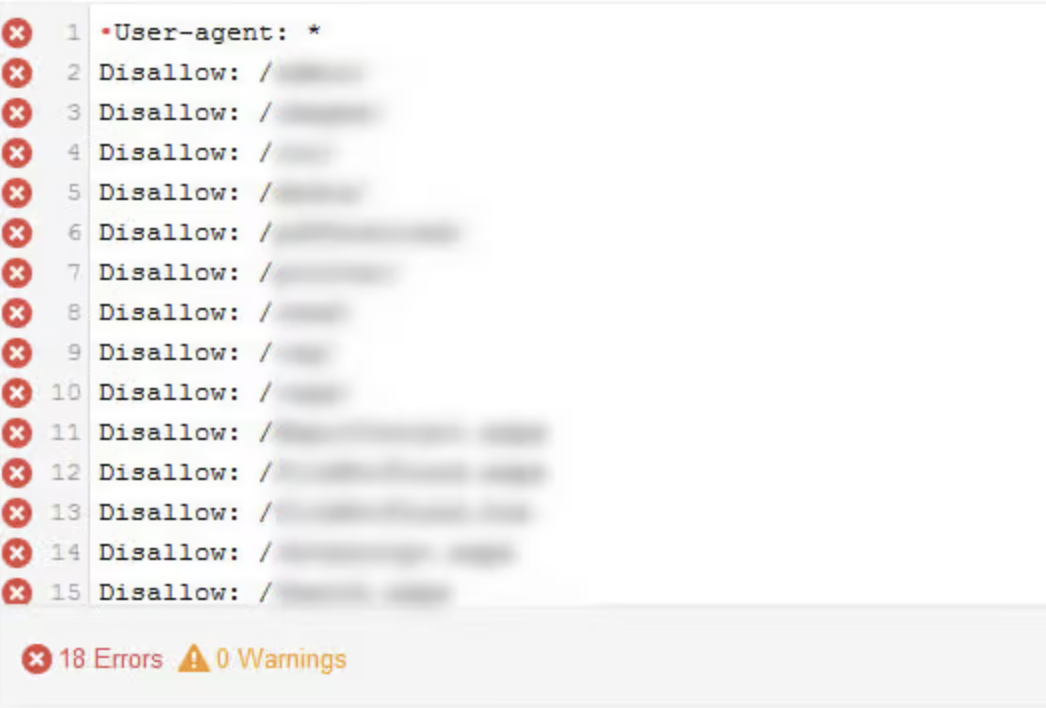

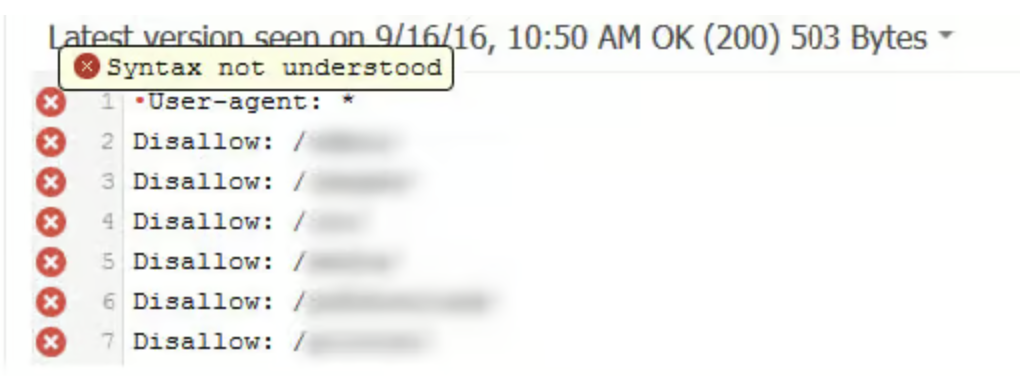

Ce caractère invisible étant placé au début du fichier, il va la plupart du temps masquer la ligne « User-agent : », qui sera donc ignorée … Et si aucun user-agent n’est présent dans votre fichier, toutes les autres lignes seront considérées comme des erreurs et de ce fait, ignorées par Google. Avec tous les problèmes SEO qui en découlent.

Voici un exemple à droite d’un fichier robots.txt en UTF-8 BOM. Cet exemple parle de lui même…

Comment identifier que mon robots.txt est en UTF-8 BOM ?

Utilisez l’outil de test du fichier robots.txt sur la Search Console de Google. Si vous voyez une croix rouge sur la première ligne, dans l’exemple la ligne User-agent : *, alors il y a de grande chance que vous ayez un problème avec le BOM.

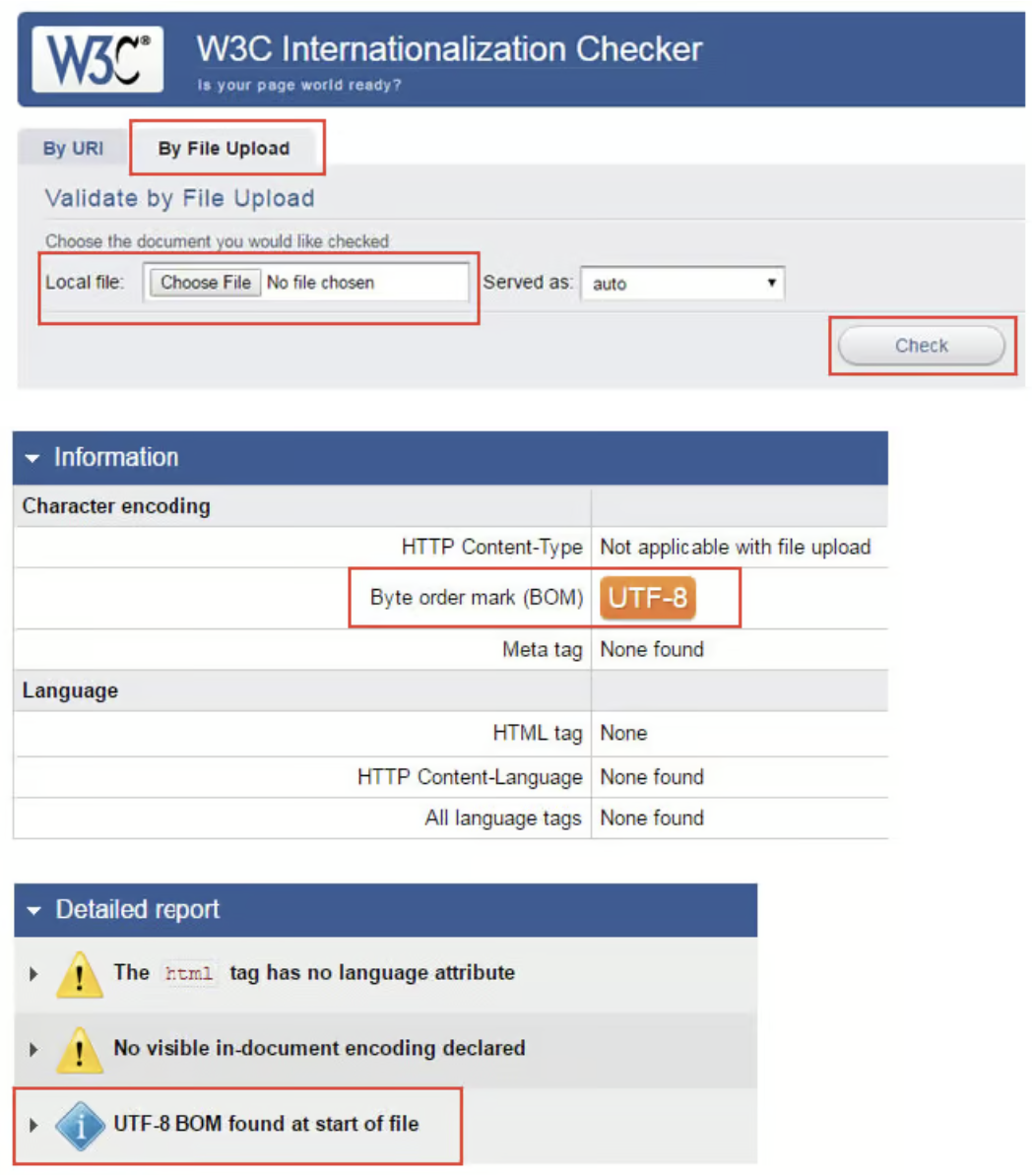

Rendez-vous sur le site W3C Internalization Checker. Vous pourrez uploader votre fichier pour vérifier la présence de UTF-8 BOM.

Comment résoudre ce problème d’UTF-8 BOM dans votre fichier robots.txt ?

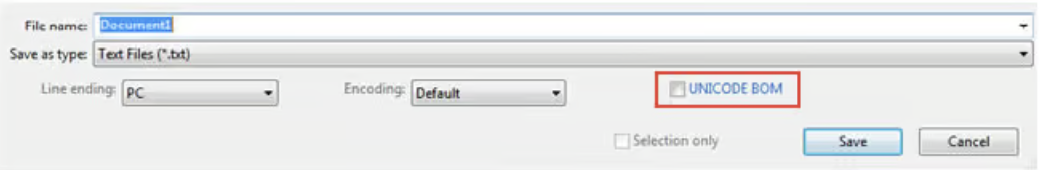

Rien de plus simple ! Utilisez un éditeur de texte type Textpad pour créer votre fichier et prenez soin de décocher si besoin la case UNICODE BOM. Bien sûr, n’utilisez pas des soft comme Microsoft Word pour générer vos fichiers… Vous pouvez ensuite retester votre fichier sur l’outil du W3C.

Appliquez votre fichier robots.txt à la racine du site et testez-le à nouveau sur la Search Console.

⚠️ Attention : Le robots.txt sert à bloquer vos URL, dossiers et fichiers, et non à les désindexer !

Si vous pensez avoir des problèmes au niveau de votre crawl ou de votre indexation, n’hésitez pas contacter notre équipe d’experts SEO !